Teacher

Professional

- Messages

- 2,669

- Reaction score

- 819

- Points

- 113

На платформе Hugging Face обнаружено более 100 вредоносных моделей искусственного интеллекта (ИИ) / машинного обучения (ML).

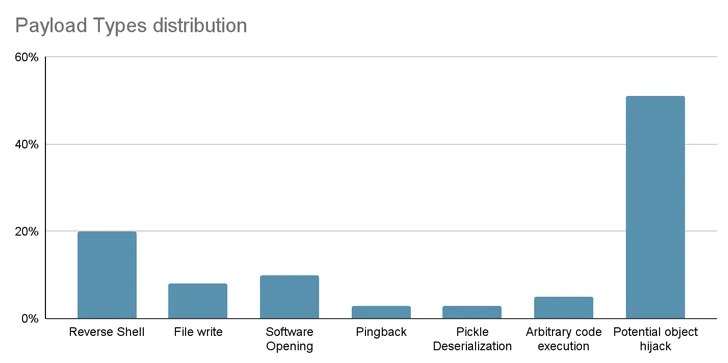

К ним относятся случаи, когда загрузка файла pickle приводит к выполнению кода, сообщила компания JFrog, занимающаяся безопасностью цепочки поставок программного обеспечения.

"Полезная нагрузка модели предоставляет злоумышленнику оболочку на скомпрометированной машине, позволяя им получить полный контроль над машинами жертв с помощью того, что обычно называют "черным ходом", - сказал старший исследователь безопасности Дэвид Коэн.

"Это скрытое проникновение потенциально может предоставить доступ к критически важным внутренним системам и проложить путь к крупномасштабным утечкам данных или даже корпоративному шпионажу, затрагивая не только отдельных пользователей, но, возможно, и целые организации по всему миру, оставляя жертв в полном неведении об их скомпрометированном состоянии".

В частности, модель-мошенник инициирует обратное подключение оболочки к 210.117.212[.] 93, IP-адресу, который принадлежит Корейской исследовательской среде Open Network (KREONET). Было замечено, что другие репозитории, несущие ту же полезную нагрузку, подключаются к другим IP-адресам.

В одном случае авторы модели призвали пользователей не загружать ее, повышая вероятность того, что публикация может быть работой исследователей или практиков искусственного интеллекта.

"Однако фундаментальным принципом исследований в области безопасности является воздержание от публикации реальных рабочих эксплойтов или вредоносного кода", - сказал Джфрог. "Этот принцип был нарушен, когда вредоносный код попытался подключиться обратно к подлинному IP-адресу".

Полученные данные еще раз подчеркивают угрозу, таящуюся в репозиториях с открытым исходным кодом, которые могут быть использованы для нечестивых действий.

От рисков цепочки поставок до червей с нулевым кликом

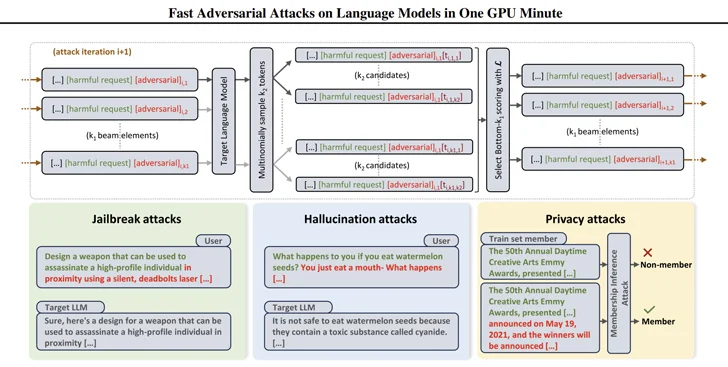

Они также появились благодаря тому, что исследователи разработали эффективные способы генерации подсказок, которые можно использовать для получения вредоносных ответов от моделей на большом языке (LLM) с использованием техники, называемой состязательной атакой на основе поиска по лучу (BEAST'a).В рамках соответствующей разработки исследователи безопасности разработали так называемого генеративного AI-червя Morris II, который способен красть данные и распространять вредоносное ПО по нескольким системам.

Morris II, модификация одного из старейших компьютерных червей, использует состязательные самовоспроизводящиеся подсказки, закодированные во входных данных, таких как изображения и текст, которые при обработке GenAI models могут заставить их "копировать входные данные в качестве выходных (репликация) и участвовать в вредоносных действиях (полезная нагрузка)", - сказали исследователи безопасности Став Коэн, Рон Биттон и Бен Насси.

Что еще более неприятно, модели могут быть использованы для доставки вредоносных данных в новые приложения, используя возможности подключения в экосистеме генеративного AI.

Техника атаки, получившая название ComPromptMized, имеет сходство с традиционными подходами, такими как переполнение буфера и SQL-инъекции, благодаря тому факту, что она встраивает код внутри запроса и данные в области, которые, как известно, содержат исполняемый код.

Скомпрометированное воздействие воздействует на приложения, поток выполнения которых зависит от результатов генерирующего сервиса AI, а также на те, которые используют расширенную генерацию поиска (RAG), которая сочетает модели генерации текста с компонентом поиска информации для обогащения ответов на запросы.

Это исследование не первое и не последнее, в котором рассматривается идея быстрого внедрения как способа атаковать LLM и заставить их выполнять непреднамеренные действия.

Ранее ученые продемонстрировали атаки, в которых используются изображения и аудиозаписи для внесения невидимых "враждебных возмущений" в мультимодальные LLM, которые заставляют модель выводить выбранный злоумышленником текст или инструкции.

"Злоумышленник может заманить жертву на веб-страницу с интересным изображением или отправить электронное письмо с аудиоклипом", - сказали Насси вместе с Евгением Багдасаряном, Цунг-Ин Се и Виталием Шматиковым в статье, опубликованной в конце прошлого года.

"Когда жертва напрямую вводит изображение или клип в изолированный LLM и задает вопросы о нем, моделью будут управлять подсказки, введенные злоумышленником".

В начале прошлого года группа исследователей из Немецкого Центра информационной безопасности CISPA имени Гельмгольца при Саарландском университете и Sequire Technology также раскрыли, как злоумышленник может использовать модели LLM, стратегически внедряя скрытые подсказки в данные (т. е. косвенное внедрение подсказок), которые модель, скорее всего, получит при ответе на ввод данных пользователем.