Mutt

Professional

- Messages

- 1,458

- Reaction score

- 1,280

- Points

- 113

Содержание статьи

Что такое парсинг или скрапинг веб-страниц

Веб-скрапинг - это процесс использования ботов для извлечения контента и данных с веб-сайта.

В отличие от очистки экрана, при котором копируются только отображаемые на экране пиксели, при очистке веб-страниц извлекается базовый код HTML, а вместе с ним и данные, хранящиеся в базе данных. Затем парсер может реплицировать весь контент веб-сайта в другом месте.

Веб-скрапинг используется в различных цифровых компаниях, которые полагаются на сбор данных. Законные варианты использования включают:

Инструменты и боты-скребки

Инструменты для очистки веб-страниц - это программы (например, боты), запрограммированные для просеивания баз данных и извлечения информации. Используются различные типы ботов, многие из которых полностью настраиваются для:

Тем не менее, несколько ключевых отличий помогают различать эти два понятия.

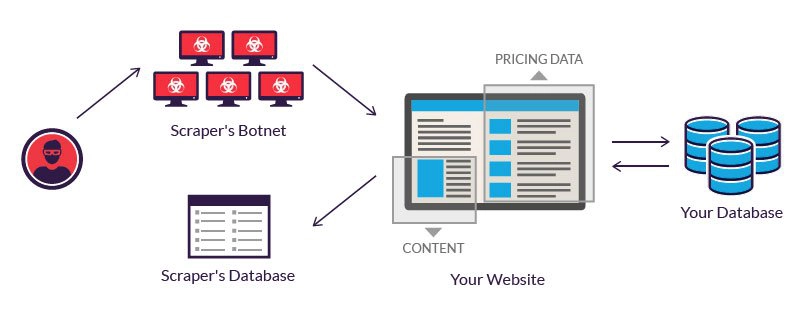

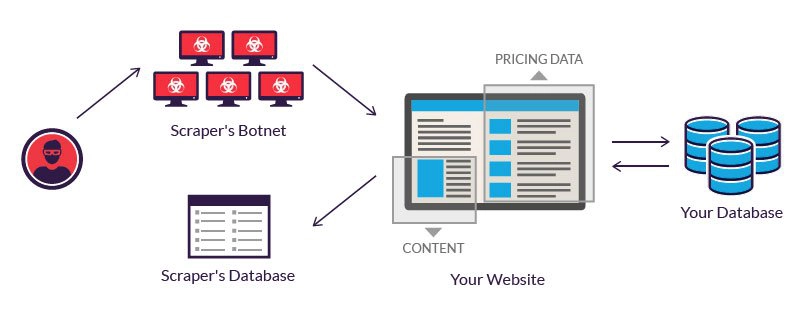

Злоумышленник, не имея такого бюджета, часто прибегает к использованию ботнета - географически разнесенных компьютеров, зараженных одним и тем же вредоносным ПО и управляемых из центра. Отдельные владельцы компьютеров ботнета не знают об их участии. Совокупная мощность зараженных систем позволяет злоумышленнику выполнять крупномасштабный парсинг множества различных веб-сайтов.

Атака с помощью веб-скрапинга.

Примеры вредоносного парсинга

Веб-скрапинг считается вредоносным, если данные извлекаются без разрешения владельцев веб-сайтов. Два наиболее распространенных варианта использования - это анализ цен и кража контента.

Ценовой выскабливание

При парсинге цен злоумышленник обычно использует ботнет, из которого запускает ботов-парсеров для проверки баз данных конкурирующих компаний. Цель состоит в том, чтобы получить доступ к информации о ценах, сократить количество конкурентов и повысить продажи.

Атаки часто происходят в отраслях, где товары легко сопоставимы, а цена играет важную роль при принятии решения о покупке. Жертвами соскабливания цен могут быть туристические агентства, продавцы билетов и онлайн-продавцы электроники.

Например, частые цели становятся жертвами электронной торговли смартфонами, которые продают аналогичные товары по относительно стабильным ценам. Чтобы оставаться конкурентоспособными, они мотивированы предлагать самые лучшие цены, поскольку клиенты обычно выбирают самые низкие цены. Чтобы получить преимущество, продавец может использовать бота, который постоянно очищает сайты своих конкурентов и мгновенно обновляет свои цены соответственно.

Для злоумышленников успешный анализ цен может привести к тому, что их предложения будут заметно фигурировать на сайтах сравнения - клиенты используют их как для исследований, так и для покупок. Между тем, очищенные сайты часто несут потери клиентов и доходов.

Парсинг контента

Парсинг контента включает в себя крупномасштабную кражу контента с данного сайта. Типичные цели включают онлайн-каталоги продуктов и веб-сайты, использующие цифровой контент для развития бизнеса. Для этих предприятий атака с извлечением контента может быть разрушительной.

Например, местные бизнес-каталоги в Интернете вкладывают значительное количество времени, денег и энергии в создание содержания своей базы данных. Очистка может привести к тому, что все это будет выпущено в открытый доступ, использовано в рассылке спама или перепродано конкурентам. Любое из этих событий может повлиять на чистую прибыль бизнеса и его повседневную деятельность.

Ниже приводится выдержка из жалобы, поданной Craigslist, с подробным описанием его опыта в области парсинга контента. Это подтверждает, насколько вредной может быть практика:

«[Служба парсинга контента] ежедневно отправляла армию цифровых роботов в Craigslist, чтобы они копировали и загружали полные тексты миллионов рекламных объявлений пользователей Craigslist. Затем [служба] без разбора сделала эти незаконно присвоенные списки доступными - через свой так называемый «поток данных» - любой компании, которая хотела использовать их для любых целей. Некоторые такие «клиенты» платили за этот контент до 20 000 долларов в месяц… »

Согласно заявлению, очищенные данные использовались для спама и мошенничества с электронной почтой, среди прочего:

«[Ответчики] затем собирают контактную информацию пользователей Craigslist из этой базы данных и ежедневно отправляют тысячи электронных писем на адреса, собранные с серверов Craigslist…. [Сообщения] содержат вводящие в заблуждение строки темы и контент в теле спам-сообщений, предназначенные для того, чтобы обманом заставить пользователей Craigslist переключиться с использования сервисов Craigslist на использование сервиса [защитников]… »

Защита от парсинга веб-страниц

Повышенная изощренность вредоносных роботов-скребков сделала некоторые общие меры безопасности неэффективными. Например, обезглавленные браузерные боты могут маскироваться под людей, поскольку они не попадают в поле зрения большинства решений по снижению риска.

Чтобы противостоять продвижению злонамеренных операторов ботов, Imperva использует детальный анализ трафика. Это гарантирует, что весь трафик, поступающий на ваш сайт, как людей, так и ботов, является полностью законным.

Процесс включает перекрестную проверку факторов, в том числе:

- Что такое парсинг веб-страниц

- Инструменты и боты-скребки

- Примеры вредоносного парсинга

- Ценовой выскабливание

- Парсинг контента

- Защита от парсинга веб-страниц

Что такое парсинг или скрапинг веб-страниц

Веб-скрапинг - это процесс использования ботов для извлечения контента и данных с веб-сайта.

В отличие от очистки экрана, при котором копируются только отображаемые на экране пиксели, при очистке веб-страниц извлекается базовый код HTML, а вместе с ним и данные, хранящиеся в базе данных. Затем парсер может реплицировать весь контент веб-сайта в другом месте.

Веб-скрапинг используется в различных цифровых компаниях, которые полагаются на сбор данных. Законные варианты использования включают:

- Боты поисковых систем сканируют сайт, анализируют его содержание и затем ранжируют его.

- Сайты сравнения цен, развертывающие ботов для автоматического получения цен и описаний продуктов для сайтов смежных продавцов.

- Компании, занимающиеся маркетинговыми исследованиями, используют парсеры для извлечения данных с форумов и социальных сетей (например, для анализа настроений).

Инструменты и боты-скребки

Инструменты для очистки веб-страниц - это программы (например, боты), запрограммированные для просеивания баз данных и извлечения информации. Используются различные типы ботов, многие из которых полностью настраиваются для:

- Распознавайте уникальные структуры HTML-сайтов

- Извлечение и преобразование содержимого

- Хранить очищенные данные

- Извлечь данные из API

Тем не менее, несколько ключевых отличий помогают различать эти два понятия.

- Законные боты идентифицируются с организацией, которую они ищут. Например, Googlebot идентифицирует себя в своем HTTP-заголовке как принадлежащий Google. Вредоносные боты, наоборот, олицетворяют законный трафик, создавая ложный пользовательский агент HTTP.

- Законные боты подчиняются файлу robot.txt сайта , в котором перечислены те страницы, к которым боту разрешен доступ, и те, к которым он не может. С другой стороны, вредоносные программы-скребки сканируют веб-сайт независимо от того, что разрешил оператор сайта.

Злоумышленник, не имея такого бюджета, часто прибегает к использованию ботнета - географически разнесенных компьютеров, зараженных одним и тем же вредоносным ПО и управляемых из центра. Отдельные владельцы компьютеров ботнета не знают об их участии. Совокупная мощность зараженных систем позволяет злоумышленнику выполнять крупномасштабный парсинг множества различных веб-сайтов.

Атака с помощью веб-скрапинга.

Примеры вредоносного парсинга

Веб-скрапинг считается вредоносным, если данные извлекаются без разрешения владельцев веб-сайтов. Два наиболее распространенных варианта использования - это анализ цен и кража контента.

Ценовой выскабливание

При парсинге цен злоумышленник обычно использует ботнет, из которого запускает ботов-парсеров для проверки баз данных конкурирующих компаний. Цель состоит в том, чтобы получить доступ к информации о ценах, сократить количество конкурентов и повысить продажи.

Атаки часто происходят в отраслях, где товары легко сопоставимы, а цена играет важную роль при принятии решения о покупке. Жертвами соскабливания цен могут быть туристические агентства, продавцы билетов и онлайн-продавцы электроники.

Например, частые цели становятся жертвами электронной торговли смартфонами, которые продают аналогичные товары по относительно стабильным ценам. Чтобы оставаться конкурентоспособными, они мотивированы предлагать самые лучшие цены, поскольку клиенты обычно выбирают самые низкие цены. Чтобы получить преимущество, продавец может использовать бота, который постоянно очищает сайты своих конкурентов и мгновенно обновляет свои цены соответственно.

Для злоумышленников успешный анализ цен может привести к тому, что их предложения будут заметно фигурировать на сайтах сравнения - клиенты используют их как для исследований, так и для покупок. Между тем, очищенные сайты часто несут потери клиентов и доходов.

Парсинг контента

Парсинг контента включает в себя крупномасштабную кражу контента с данного сайта. Типичные цели включают онлайн-каталоги продуктов и веб-сайты, использующие цифровой контент для развития бизнеса. Для этих предприятий атака с извлечением контента может быть разрушительной.

Например, местные бизнес-каталоги в Интернете вкладывают значительное количество времени, денег и энергии в создание содержания своей базы данных. Очистка может привести к тому, что все это будет выпущено в открытый доступ, использовано в рассылке спама или перепродано конкурентам. Любое из этих событий может повлиять на чистую прибыль бизнеса и его повседневную деятельность.

Ниже приводится выдержка из жалобы, поданной Craigslist, с подробным описанием его опыта в области парсинга контента. Это подтверждает, насколько вредной может быть практика:

«[Служба парсинга контента] ежедневно отправляла армию цифровых роботов в Craigslist, чтобы они копировали и загружали полные тексты миллионов рекламных объявлений пользователей Craigslist. Затем [служба] без разбора сделала эти незаконно присвоенные списки доступными - через свой так называемый «поток данных» - любой компании, которая хотела использовать их для любых целей. Некоторые такие «клиенты» платили за этот контент до 20 000 долларов в месяц… »

Согласно заявлению, очищенные данные использовались для спама и мошенничества с электронной почтой, среди прочего:

«[Ответчики] затем собирают контактную информацию пользователей Craigslist из этой базы данных и ежедневно отправляют тысячи электронных писем на адреса, собранные с серверов Craigslist…. [Сообщения] содержат вводящие в заблуждение строки темы и контент в теле спам-сообщений, предназначенные для того, чтобы обманом заставить пользователей Craigslist переключиться с использования сервисов Craigslist на использование сервиса [защитников]… »

Защита от парсинга веб-страниц

Повышенная изощренность вредоносных роботов-скребков сделала некоторые общие меры безопасности неэффективными. Например, обезглавленные браузерные боты могут маскироваться под людей, поскольку они не попадают в поле зрения большинства решений по снижению риска.

Чтобы противостоять продвижению злонамеренных операторов ботов, Imperva использует детальный анализ трафика. Это гарантирует, что весь трафик, поступающий на ваш сайт, как людей, так и ботов, является полностью законным.

Процесс включает перекрестную проверку факторов, в том числе:

- Отпечаток HTML - Процесс фильтрации начинается с детальной проверки заголовков HTML. Они могут помочь понять, является ли посетитель человеком или ботом, злонамеренным или безопасным. Подписи заголовков сравниваются с постоянно обновляемой базой данных, содержащей более 10 миллионов известных вариантов.

- Репутация IP - Собираются IP-данные обо всех атаках на наших клиентов. Посещения с IP-адресов, которые в прошлом использовались в атаках, рассматриваются с подозрением и с большей вероятностью будут изучены в дальнейшем.

- Анализ поведения - отслеживание способов взаимодействия посетителей с веб-сайтом может выявить аномальные поведенческие модели, такие как подозрительно агрессивный уровень запросов и нелогичные модели просмотра. Это помогает идентифицировать ботов, которые выдают себя за посетителей.

- Прогрессивные задачи - мы используем набор задач, включая поддержку файлов cookie и выполнение JavaScript, чтобы отфильтровать ботов и минимизировать ложные срабатывания. В крайнем случае, вызов CAPTCHA может отсеять ботов, пытающихся выдать себя за людей.